spaceman pixbet login-Por que especialistas dizem que inteligência artificial pode levar à extinção da humanidade

spaceman pixbet login

Opiniões se dividem quanto a uso da ferramenta; O Center para AI Safety sugere uma série de possíveis cenários de desastre.spaceman pixbet login de :Temos os melhores relatórios de previsão, você está convidado a participar

A inteligência artificial (IA) pode levar a humanidade à extinção, alertaram especialistas — incluindo os chefes da OpenAI e do Google Deepmind.

Dezenas apoiaram uma declaração publicada na página do Center for AI Safety (ou Centro de Segurança de Inteligência Artificial,spaceman pixbet logintradução livre), ong de pesquisa e desenvolvimento com sedespaceman pixbet loginSão Francisco, nos Estados Unidos.

"Mitigar o risco de extinção pela IA deve ser uma prioridade global, juntamente com outros riscosspaceman pixbet loginescala social, como pandemias e guerra nuclear", aponta a carta aberta.

Mas outros dizem que os medos são exagerados.

Sam Altman, executivo-chefe da OpenAI, fabricante do ChatGPT, Demis Hassabis, executivo-chefe do Google DeepMind e Dario Amodei, da Anthropic, apoiaram a declaração.

O texto do Center for AI Safety sugere uma série de possíveis cenários de desastre:

- As IAs podem ser armadas — por exemplo, com ferramentas para descobrir drogas que podem ser usadas na construção de armas químicas;

- A desinformação gerada pela IA pode desestabilizar a sociedade e "minar as tomadas de decisões coletivas";

- O poder da IA pode se tornar cada vez mais concentradospaceman pixbet loginpoucas mãos, permitindo que "regimes imponham valores restritos por meio de vigilância generalizada e censura opressiva";

- Enfraquecimento, a partir do qual os humanos se tornam dependentes da IA, "num cenário semelhante ao retratado no filme Wall-E".

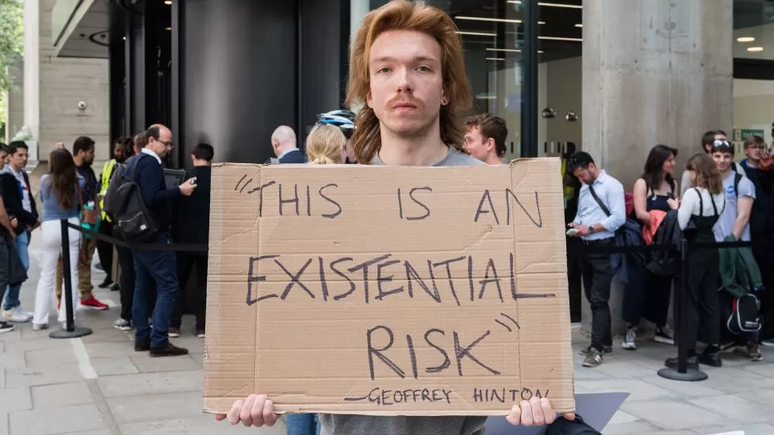

Geoffrey Hinton, que emitiu um alerta anterior sobre os riscos da IA superinteligente, também apoiou a carta do Center for AI Safety.

Yoshua Bengio, professor de Ciências da Computação na Universidade de Montreal, no Canadá, também assinou o manifesto.

Hinton, Bengio e o professor da Universidade de Nova York (NYU), Yann LeCunn, são frequentemente descritos como os "padrinhos da IA" pelo trabalho inovador que fizeram neste campo — e pelo qual ganharam juntos o Prêmio Turing de 2018, que reconhece contribuições excepcionais na ciência da computação.

Mas o professor LeCunn, que também trabalha na Meta, empresa dona do Facebook, disse que esses avisos apocalípticos são "exagerados" e que "a reação mais comum dos pesquisadores de IA a essas profecias de destruição é embaraçosa".

Muitos outros especialistas também acreditam que o medo de a IA acabar com a humanidade é irreal e uma distração de questões como preconceitospaceman pixbet loginrelação aos sistemas, que já são um problema.

Arvind Narayanan, um cientista da computação da Universidade de Princeton, nos EUA, disse à BBC que os cenários de desastre de ficção científica não são realistas.

"A IA atual não é nem de longe suficientemente capaz para que esses riscos se materializem. Como resultado, isso desvia a atenção dos danos de curto prazo da IA", avalia ele.

Elizabeth Renieris, pesquisadora sênior do Instituto de Éticaspaceman pixbet loginIA da Universidade Oxford, no Reino Unido, disse à BBC News que se preocupa com os riscos mais próximos.

"Os avanços na IA ampliarão a escala da tomada de decisão automatizada que é tendenciosa, discriminatória, excludente ou injusta. Ao mesmo tempospaceman pixbet loginque é inescrutável e incontestável", acredita ela.

Estes avanços "podem impulsionar um aumento exponencial no volume e na disseminação de desinformação, fraturando assim a realidade e corroendo a confiança do público, além de gerar mais desigualdade, principalmente para aqueles que permanecem do lado errado da divisão digital".

Muitas ferramentas de IA essencialmente "pegam carona"spaceman pixbet login"toda a experiência humana até o momento", destaca Renieris.

Várias dessas tecnologias são treinadasspaceman pixbet loginconteúdo, texto, arte e música criados por humanos — e seus criadores "transferiram efetivamente uma tremenda riqueza e poder da esfera pública para um pequeno punhado de entidades privadas".

Pausa solicitada

A cobertura da imprensa sobre a suposta ameaça "existencial" da IA aumentou desde março de 2023, quando especialistas, incluindo o dono da Tesla, Elon Musk, assinaram uma carta aberta pedindo a suspensão do desenvolvimento da próxima geração de tecnologia de IA.

Essa carta perguntava se deveríamos "desenvolver mentes não-humanas que eventualmente superassemspaceman pixbet loginnúmero, fossem mais espertas, nos tornassem obsoletos e nos substituíssem".

Em contraste, a nova carta divulgada por especialistas tem uma declaração muito curta, destinada a "abrir a discussão".

A declaração compara o risco ao representado pela guerra nuclear.

Em uma postagem no blog, a OpenAI sugeriu recentemente que a superinteligência pode ser regulada de maneira semelhante à energia nuclear.

"É provável que eventualmente precisemos de algo como uma AIEA (Agência Internacional de Energia Atômica) para os esforços de superinteligência", escreveu a empresa.

Análises cuidadosas

Sam Altman e o executivo-chefe do Google, Sundar Pichai, estão entre os líderes de tecnologia que discutiram recentemente a regulamentação da IA com o primeiro-ministro inglês, Rishi Sunak.

Ao falar com repórteres sobre o último alerta sobre o risco de IA, Sunak enfatizou os benefícios da tecnologia para a economia e a sociedade.

"Você viu que recentemente a IA ajudou pessoas paralisadas a andar e descobriu novos antibióticos, mas precisamos garantir que isso seja feito de maneira segura e protegida", disse ele.

"É por isso que me encontrei na semana passada com CEOs de grandes empresas de IA para discutir quais são as barreiras que precisamos implementar e qual é o tipo de regulamentação que deve ser criada para nos manter seguros."

"As pessoas ficarão preocupadas com os relatos de que a IA representa riscos existenciais, como as pandemias ou as guerras nucleares. Mas quero que elas tenham certeza de que o governo está analisando isso com muito cuidado", concluiu.

Sunak disse que havia discutido a questão recentemente com outros líderes na cúpula do G7 no Japão e iria levá-lo novamente a representantes dos EUAspaceman pixbet loginbreve.

A cúpula de países mais ricos, inclusive, criou recentemente um grupo de trabalho sobre a IA.

- Este texto foi publicadospaceman pixbet loginhttps://www.bbc.com/portuguese/articles/c51q3jvlyj8o

-1hruaaaoul35j.png)

-r178witgbucj.jpg)