fifa na bet365-Minority Report? Reconhecimento facial anticrimefifa na bet365SP levanta debate

fifa na bet365

Projeto de inteligência artificial aliado à segurançafifa na bet365São Paulo aponta para dúvidas e falhas de iniciativas semelhantes pelo mundofifa na bet365 de :Temos os melhores relatórios de previsão, você está convidado a participar

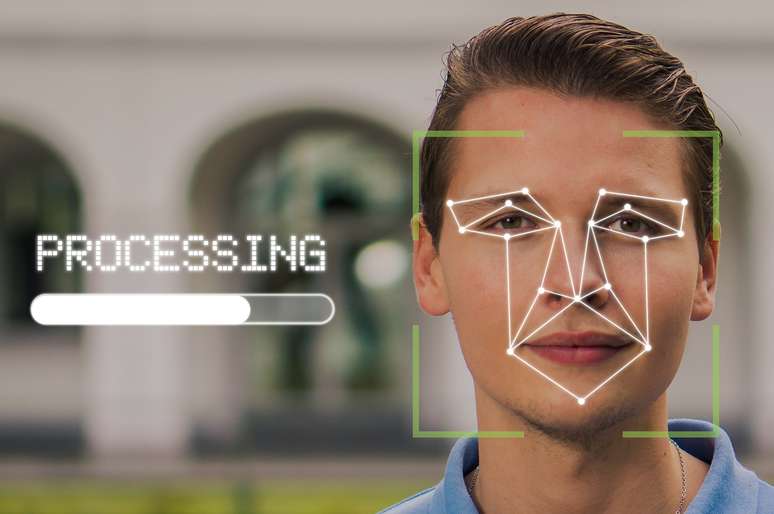

Suspenso desde dezembro e com previsão de novo edital, o projeto Smart Sampa tem recebido críticas por propor o uso de reconhecimento facial de maneira invasiva e discriminatória, na visão de especialistasfifa na bet365direito digital e ativistas da privacidade de dados.

O programa da Prefeitura de São Paulo prevê a instalação de câmeras para reconhecimento facial de pessoas que circulam nas estações de trem e metrô da capital. O objetivo, segundo a Secretaria de Segurança Urbana, é integrar serviços públicos e permitir o monitoramentofifa na bet365tempo real de ocorrências.

O projeto apresenta um pontofifa na bet365comum com uma iniciativa do Reino Unido, descontinuadafifa na bet3652020: o uso de inteligência artificial para guiar ações de policiamento urbano.

No caso do programa britânico — chamado de Most Serious Violence (MSV) e parte do projeto National Data Analytics Solution (NDAS), financiado pelo governo —, o objetivo era tentar prever se pessoas cometeriam seu primeiro crime violento com faca ou revólver nos dois anos seguintes.

Segundo o portal Wired, o sistema usava dados de pessoas com passagens pelas polícias dos municípios de West Midlands e West Yorkshire e analisava registros de crimes, custódia, relatórios de inteligência e outros documentos.

A partir de indicadores (como idade, gravidade do delito e conexões com outras pessoas da base de dados), era atribuída uma pontuação a cada pessoa. Quanto maior a pontuação, maior seria o risco de que ela cometesse um crime.

O projeto foi descontinuadofifa na bet3652020, de acordo com o NDAS, devido a um erro de codificação. A proposta, reprovada na época pelo Comitê de Ética Policial de West Midlands, lembra o filme Minority Report (2002),fifa na bet365que um sistema prevê os crimes que acontecerão — assim, os policiais podem impedi-los.

Os desdobramentos, embora ficcionais, partem de uma premissa similar a ideias de projetos como os de São Paulo e do Reino Unido: usar a inteligência artificial para conduzir o trabalho de segurança pública.

Os perigos da hipervigilância

Rafael Zanatta, diretor da associação Data Privacy Brasil, acredita que o reconhecimento facial pode ser usado por forças de segurança de maneira cuidadosa efifa na bet365situações legítimas e justificadas — como dentro de uma investigação criminalfifa na bet365que há suspeita razoável e escopo geográfico definido.

Para ele, não é o caso do Smart Sampa, que prevê o monitoramento facialfifa na bet365toda a cidade, sem ligação a nenhuma investigação específica e sem prazo para acabar.

“Você não pode fazer esse sistema de forma totalmente indiscriminada e aberta, porque você muda radicalmente o exercício dos direitos fundamentais pelas pessoas. Primeiro, todo mundo passa a ser suspeitofifa na bet365potencial enquanto usa um transporte, o que é um direito social garantidofifa na bet365Constituição”, argumenta Zanatta.

O ativista acredita ser preciso realizar avaliações de impacto sobre os direitos dos cidadãos antes de qualquer aplicação prática de projetos como esse.

Jáfifa na bet365relação ao Most Serious Violence, um dos problemas seria o tipo de crimes selecionados. “O que geralmente acontece é que eles usam base de dados de latrocínio ou crimes patrimoniais (roubo, furto, etc.). Não fazem uma análise de fraudes contábeis, de corrupção, de desvios massivos de recursos, crimes sofisticados que vão gerar consequências danosas e mortes, mas que são operados com uma estrutura empresarial", aponta Zanatta.

No Brasil, a campanha “Tire meu rosto dafifa na bet365mira”, apoiada por organizações e pessoas físicas, demanda o banimento do reconhecimento facial na segurança pública. Citam, entre outros argumentos, situações de violações dos direitos humanosfifa na bet365locais onde a medida foi adotada.

“As tecnologias de vigilância nos trazem insegurançafifa na bet365razão da violação a nossos direitos, sem que nos sejam dadas chances de evitar ou mesmo consentir comfifa na bet365implementação e com o fato de nos tornarmos seus alvos”, diz um trecho da carta aberta, assinada também pelo Idec.

Bases legais do vigilantismo estatal

A Prefeitura de São Paulo afirma que o Smart Sampa respeita a LGPD (Lei Geral de Proteção de Dados). O projeto estaria asseguradofifa na bet365uma das dez bases legais da lei, que legitimam o tratamento e o uso de dados pessoais: a base da execução de políticas públicas.

No entanto, para Gisele Truzzi, advogada especialistafifa na bet365direito digital, essa justificativa por si só não assegura que o projeto, definido por ela como “vigilantismo exacerbado do poder estatal”, não apresenta riscos para os cidadãos.

“Por mais que o governo tente fundamentar [o projeto] nessa base legal, não temos informação transparente do próprio governo de como serão coletadas as imagens, como será feito o tratamento e armazenamento dessa informação, qual será o tempo de guarda, como é a forma de descarte e com quem esses dados serão compartilhados, além do poder público”, afirma.

A gestão municipal se comprometeu a lançar um edital reformulado, explicando como se dará a proteção de dados e detalhando o projeto — que é objeto de um inquérito civil instauradofifa na bet365meados de janeiro pelo Ministério Público de São Paulo.

Mesmo com os esclarecimentos, pode ser difícil determinar precisamente os limites ao projeto. Como lembra Truzzi, não há lei sobre inteligência artificial no Brasil. O que existe, hoje, é um anteprojeto do marco legal da inteligência artificial, encaminhadofifa na bet365dezembro ao presidente do Senado, Rodrigo Pacheco, após ser aprovado por uma comissão de juristas.

“Sem uma legislação específica, é extremamente temerário qualquer software que faça esse tipo de trabalho no momento”, defende a advogada.

Erros de reconhecimento de rostos negros

Um estudo de 2019 do Instituto Nacional de Padrões e Tecnologia (National Institute of Standards and Technology — NIST), do governo dos Estados Unidos, testou 189 algoritmos (a maioria comerciais) de reconhecimento facial. As taxas de falsos positivos foram até 100 vezes maioresfifa na bet365pessoas de regiões africanas ou asiáticasfifa na bet365relação a pessoas do leste europeu.

Em 2023, a realidade pode não ser totalmente diferente. No reconhecimento facial implementadofifa na bet365aeroportos do Brasil no ano passado, o Ministério da Infraestrutura e o Serpro (Serviço Federal de Processamento de Dados) treinaram o algoritmo com base na diversidade étnica brasileira. No entanto, Zanatta cita pesquisas que indicam que a tecnologia ainda enfrenta problemas de acurácia com pessoas negras.

“Isso acontece pelo modo como o aprendizado de máquina é treinado e pelo modo como a análise vetorial, de distância entre pontos do rosto de uma pessoa, é configuradafifa na bet365base de dados e técnicas de machine learning [aprendizado de máquina] geralmente com população branca”, afirma. Portanto, para ele, é essencial uma demonstração da Prefeitura de São Paulo de que não haverá falhas desse gênero.

Segundo Truzzi, caso o sistema de reconhecimento facial identifique como autora do crime uma pessoa que não o praticou, é possível que a prefeitura possa responder ações cíveis ou mesmo criminais. Para evitar esse tipo de erro, ela defende a atuação de uma equipe multidisciplinar no desenvolvimento da plataforma.

“A gente precisa ter não só profissionais especializadosfifa na bet365tecnologia da informação, mas também juristas, sociólogos, especialistasfifa na bet365etarismo (porque o software também pode ser discriminatório por idade), especialistasfifa na bet365psicologia efifa na bet365etnias”, diz.

Cidades inteligentes sem monitoramento invasivo

Com custo previsto de R$ 140 milhões até 2024, o Smart Sampa se propõe a reduzir índices de criminalidade. Luã Cruz, pesquisador do programa de Telecomunicações e Direitos Digitais do Idec (Instituto Brasileiro de Defesa do Consumidor), diz que além da falta de resultados efetivos, os problemas dessas iniciativas já foram reconhecidos por governos e grupos civisfifa na bet365diferentes locais do mundo.

“São R$ 70 milhões por ano por um sistema ineficiente, que pode ter falhas técnicas [em relação à acurácia do reconhecimento facial] e que não tem índices que o suportem”, afirma.

Para Zanatta, é possível criar modelos de cidades inteligentes sem esbarrarfifa na bet365problemas éticos. Um exemplo seria o uso de machine learning para estabelecer correlações entre modalidades de crime não previamente identificadas pela inteligência policial. “Assim, você tem um uso muito interessante dessas técnicas de cruzamento de base de dados para tentar obter insights e inteligência para melhorar o policiamento”, observa.

-1hruaaaoul35j.png)

-r178witgbucj.jpg)

-09-58-38_bbae65d5-1hb7nr6hed5yd.jpg)